2024年6月19日(水)にオンラインで開催された「VIVE Mars CamTrack Studio Edition 新製品発売記念セミナー」についてご紹介します。

主催 :株式会社Too

講師 :株式会社Too クリエイティブアカウント部 吉田 博行

株式会社Too クリエイティブアカウント部 村杉 卓也

バーチャルプロダクションの概要

株式会社Tooで映像関係の技術を担当している村杉です。バーチャルプロダクションには、「インカメラVFXと言われるLEDのバーチャルプロダクション」と、「グリーンのバーチャルプロダクション」の2種類があります。

今回ご紹介するVIVE Mars(ヴァイブ・マーズ)は、両方に対応しています。Unreal Engine(以下、UE)やUnityなどを使って、インカメラVFXとグリーンバックをリアルタイムに合成していくシステムになっています。

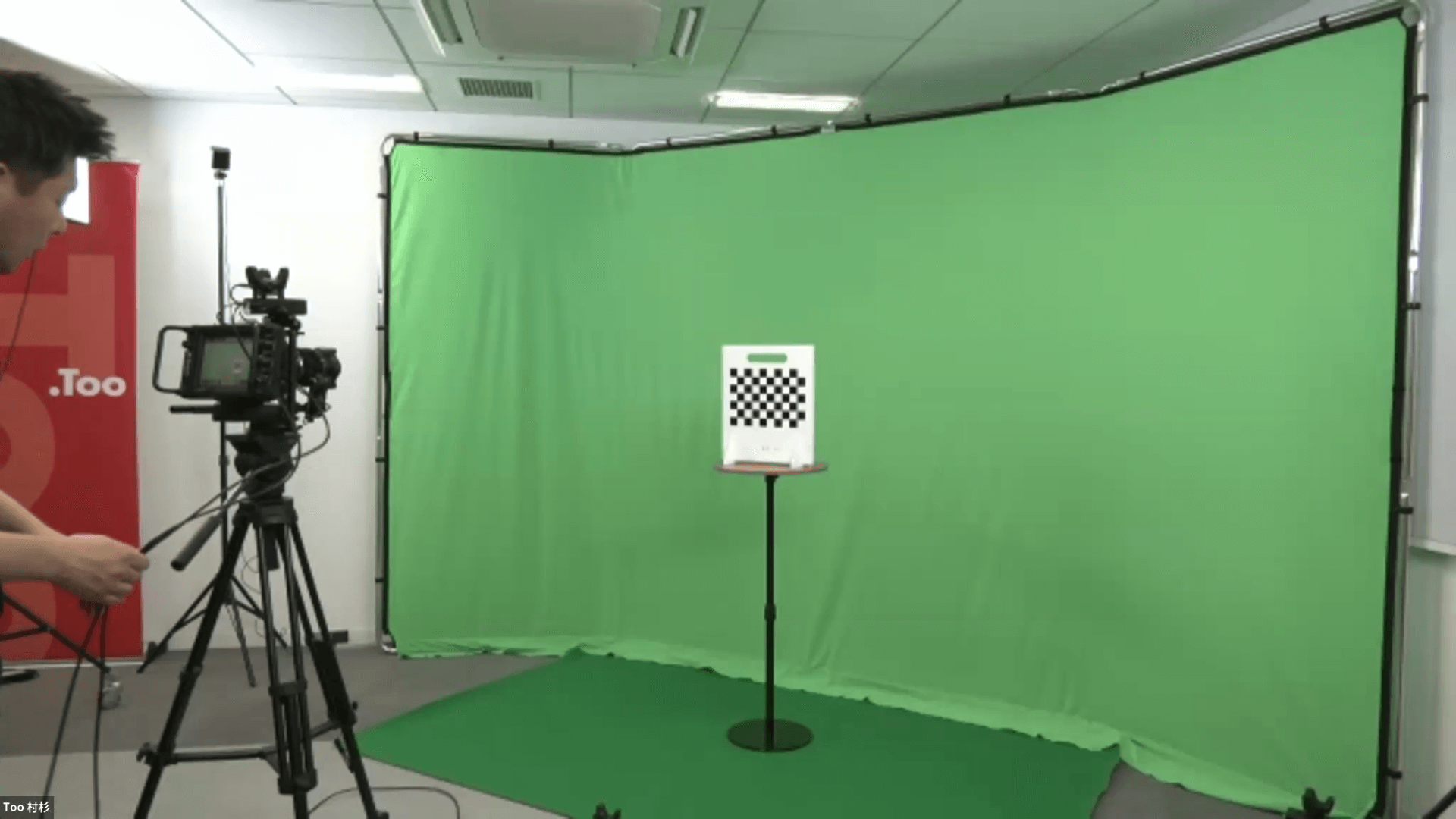

グリーンのバーチャルプロダクションの場合、画像の弊社のスタジオを見て分かる通り、それほど大きくありません。高級な物を使っているわけでもないため、このような環境でもできるということを理解いただいたうえで、良いところや悪いところを知ってもらえればと思います。

VIVE Mars CamTrack Studio Editionのご紹介

早速ですが、今回発売されたVIVE Mars CamTrack Studio Edition(以下、Studio Edition)を紹介していきます。

VIVE Mars CamTrackとの違い

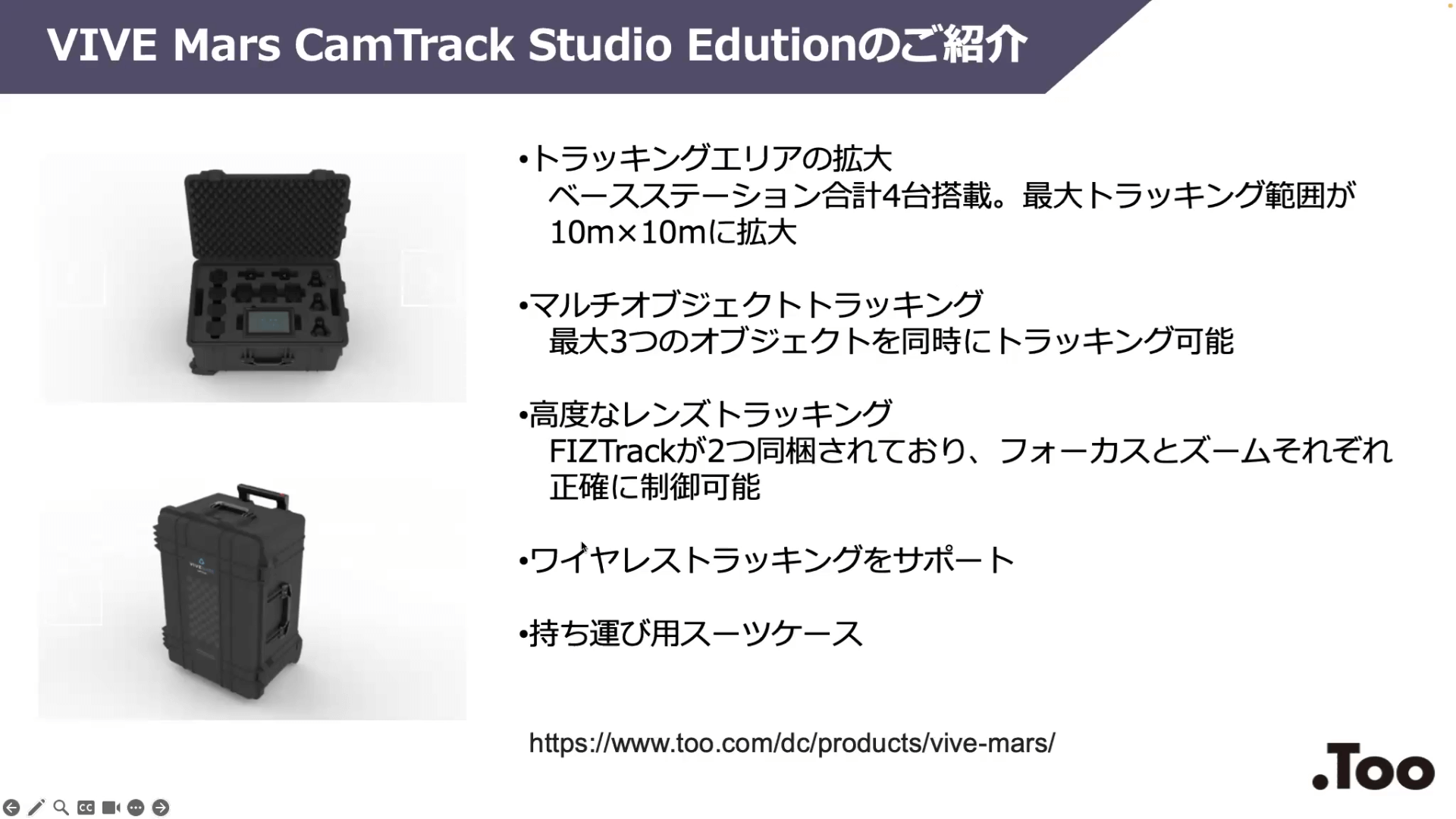

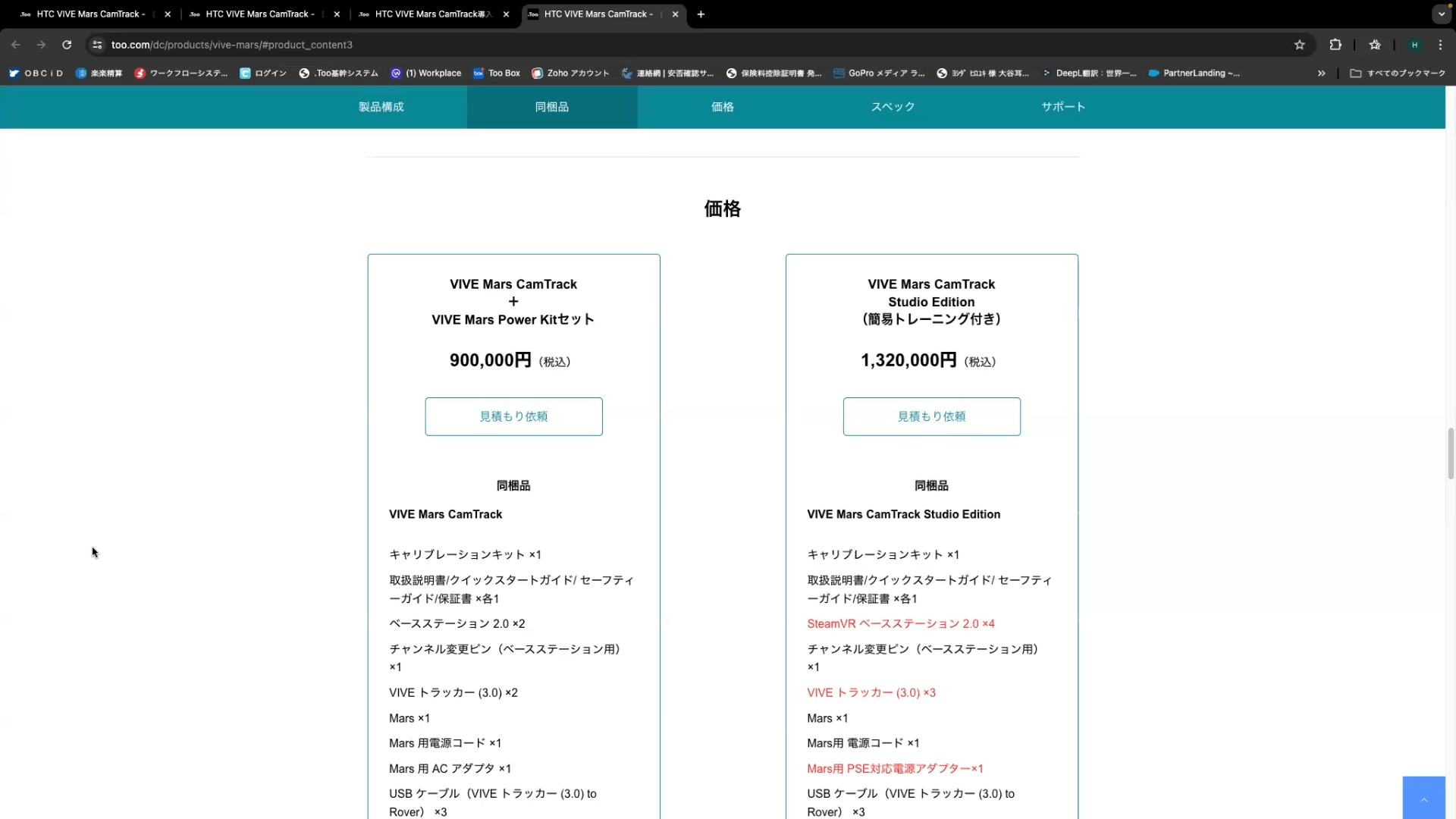

こちらの画面では、拡大機能や通常のVIVE Mars CamTrack(以下、VIVE Mars)との差を記載しています。約1年前(2023年6月)から、弊社でVIVE Marsの取り扱いを開始しました。税込90万円で販売しています。

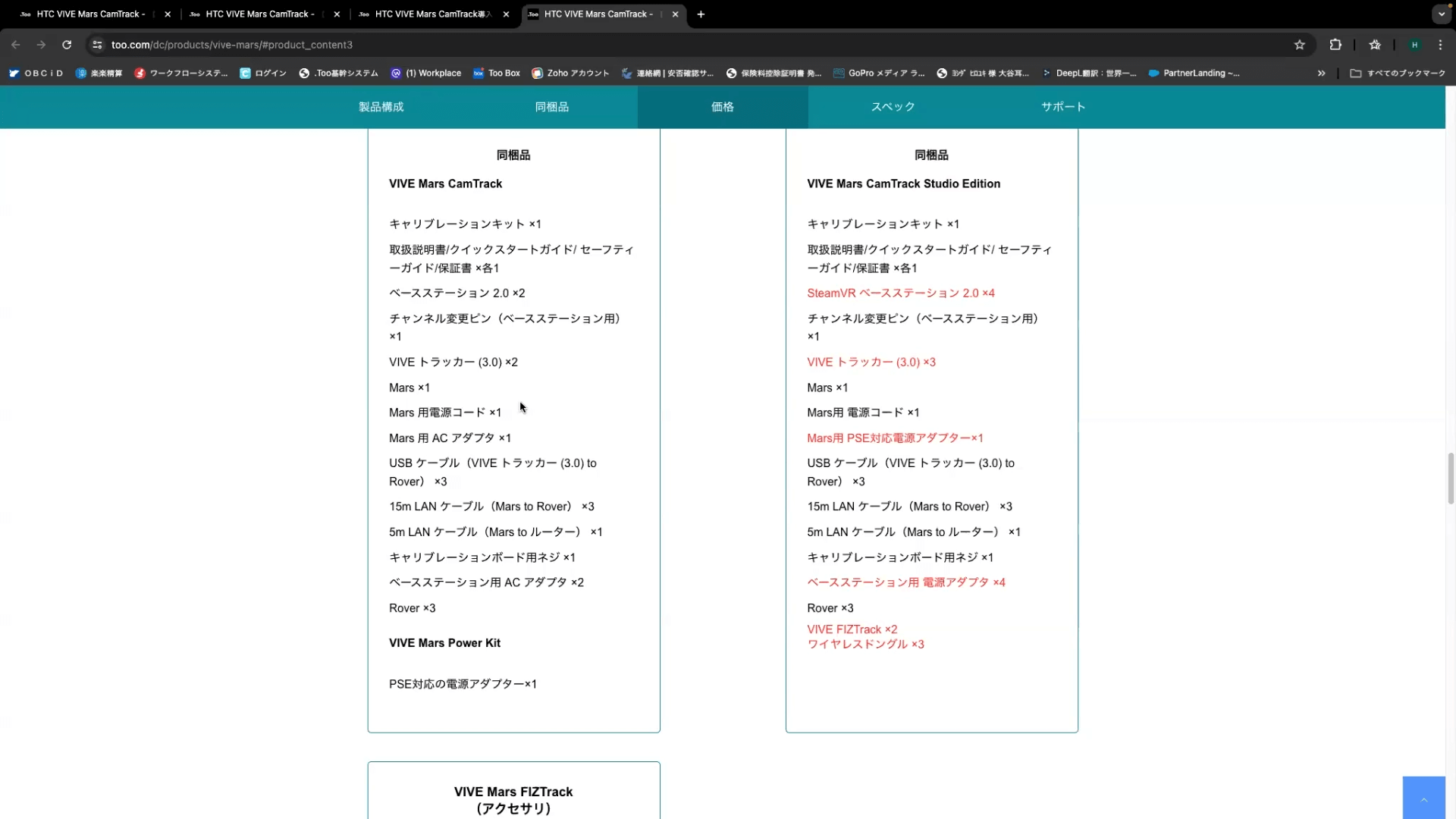

画像の左側が通常のパッケージで、右側が今回ご紹介する「Studio Edition」です。赤文字の記載が通常版と異なっているところになります。右側のStudio Editionでは、ベースステーションが4つ入っています。それに伴い、ベースステーション用の電源アダプターも4つに変更されています。

VIVEトラッカー(3.0)に関しては、通常版の2個に対して3個に増えています。また、VIVE Marsでは、本国から出てくる状態の電源コードが国内のPSEに対応していないタイプのため、別梱包でPSE対応のアダプターを入れていました。今回のStudio Editionの国内販売においては、最初からPSEに対応しているアダプターが入っています。

『VIVE FIZTrack(以下、FIZTrack)』は、VIVE Marsの発売後に出てきたオプションです。ズームやフォーカスをしたり、アイリスの数値をエンコードするためのエンコーダーとして動作することができます。FIZTrackが発売されてからシステム導入いただくケースが非常に多かったため、Studio Editionでは最初から2つ付くようになりました。

『ワイヤレスドングル』は、Studio Edition特有のものになります。通常は、VIVE Mars自体が赤外線のセンサーで、ベースステーションからカメラの下に付いているトラッカーとローバーの位置を検知して本体の状態を送っています。ローバーと本体はLANケーブルで繋がれているのですが、Studio Editionでは線が無くてもワイヤレス接続できるドングルが付いています。数量は、ローバーとトラッカーと同様3個入っています。

ワイヤレスドングルは、Studio Editionに含まれますが、単品販売はしない予定です。そのため、通常版のVIVE Marsをお持ちの方がワイヤレスドングルだけを購入することはできない仕様になっています。

また、ベースステーションが4つになったことで、通常2つで5m²だったものが10m²までトラッキングエリアが拡大されました。トラッカーも2つから3つに増えているため、オブジェクトを最大3つトラッキング可能になります。

上記写真にある専用のスーツケースに入って納品されるため、全てが収まった状態のケースで移動することができます。

VIVE Mars CamTrack StudioEditionデモ

ここからは実際の製品のデモに関して紹介します。

仕様紹介

実際に製品を動かしながら見ていきます。このVIVE Marsの本体には、Windows OSが入っています。

背面には、LANケーブルやタイムコード、リファレンスなどを入れる口がありますが、新しくStudio Editionで使うポートは一番左にあるUSBのポートです。ここに付属のドングルを挿すと、最大3つまでワイヤレスで繋げるようになります。今回はご用意できなかったため、またご紹介できる機会を作りたいと考えています。

また、トラッカーとローバーは基本的にセットで使う製品です。しかし、ワイヤレスで使う場合であればトラッカーは基本的に必要ですが、ローバーは不要になる可能性が高いです。トラッカーのみになるということは、ズームやフォーカス、アイリスが使えるFIZTrackが一緒に使えなくなります。

そのため、ワイヤレスで使う場合は基本的には設定を変えないようにします。フォーカスやズームを適宜変えたい場合は、ローバーとセットで有線で使うということになります。

ベースステーションは特に進化していませんが、BluetoothでMars本体と繋がるため、最大4つまで使えます。付属は通常版だと2つですが、Studio Editionの場合は4つ付いてます。よく入荷待ちになるため、数ヶ月待つ可能性もあります。10m²ほどのサイズのスタジオであれば、Studio Editionをご検討いただければと思います。

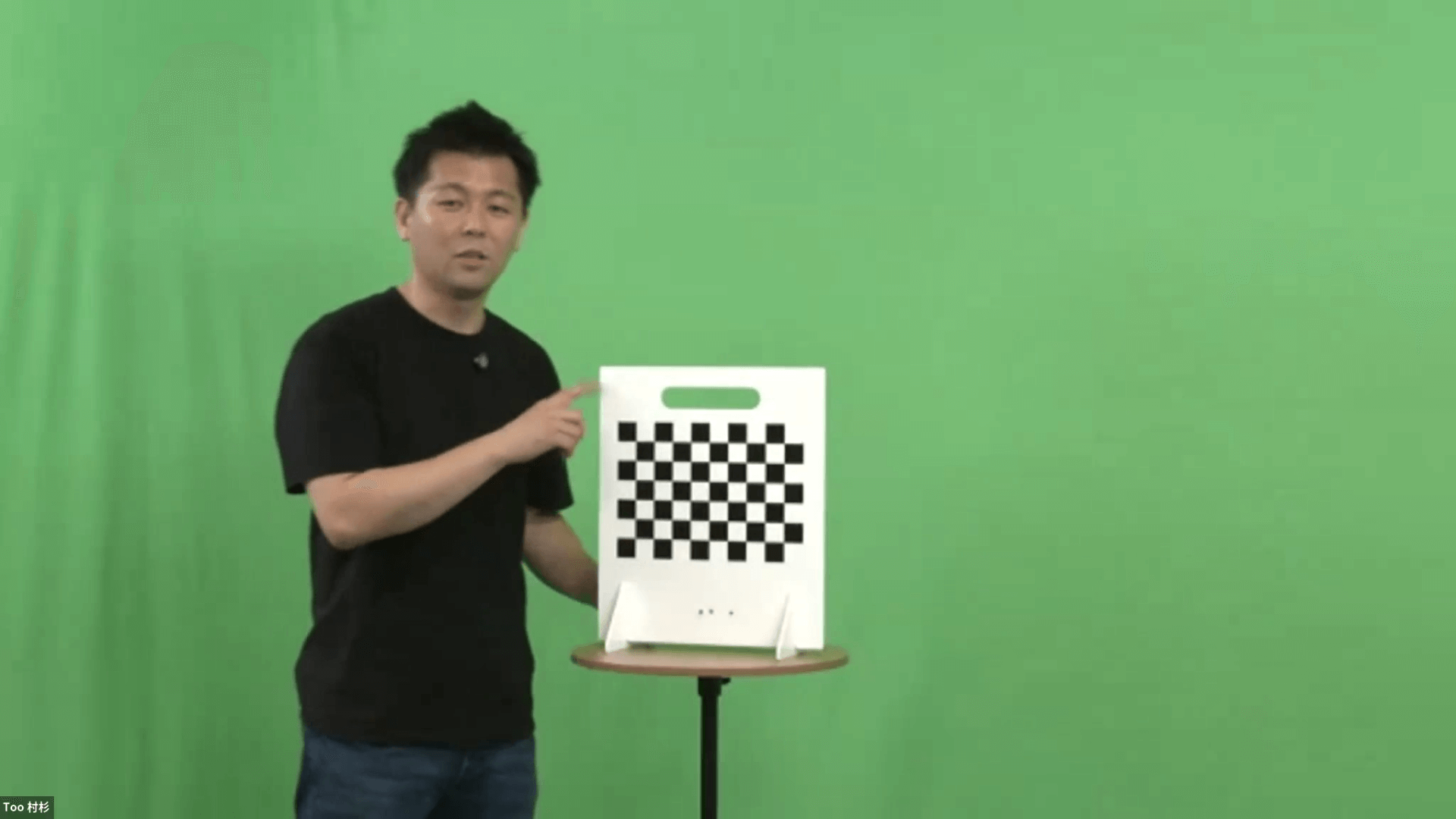

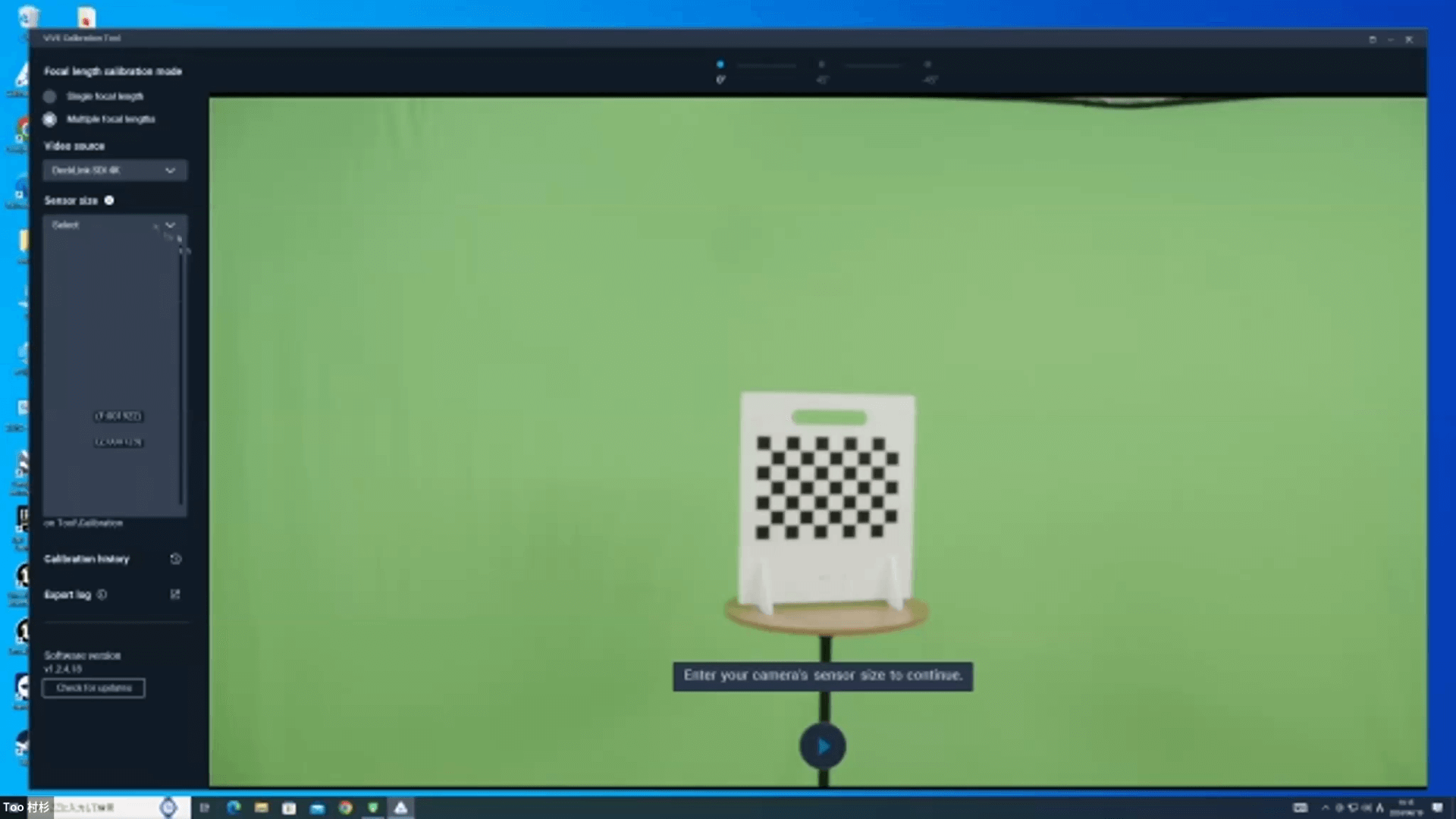

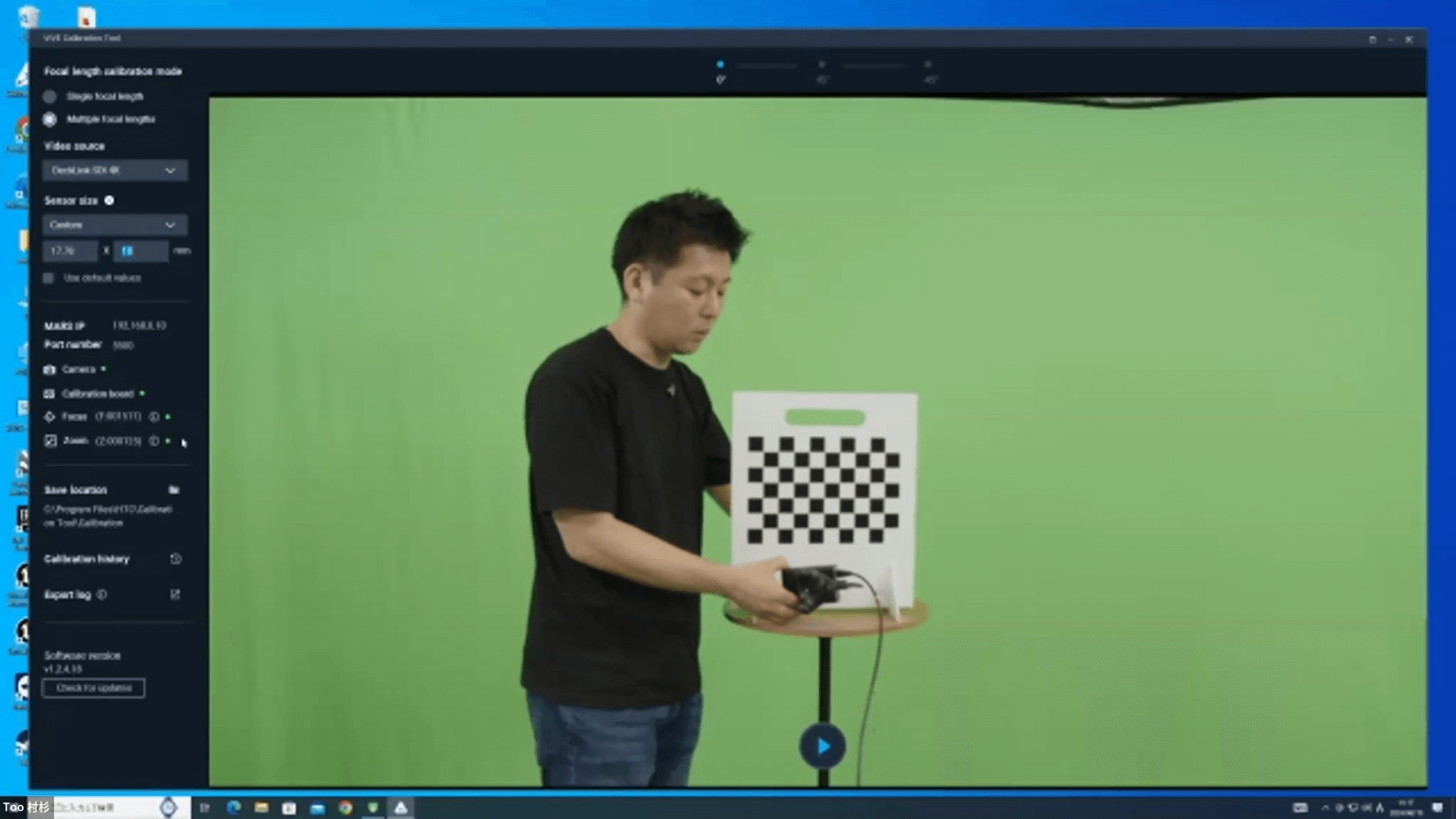

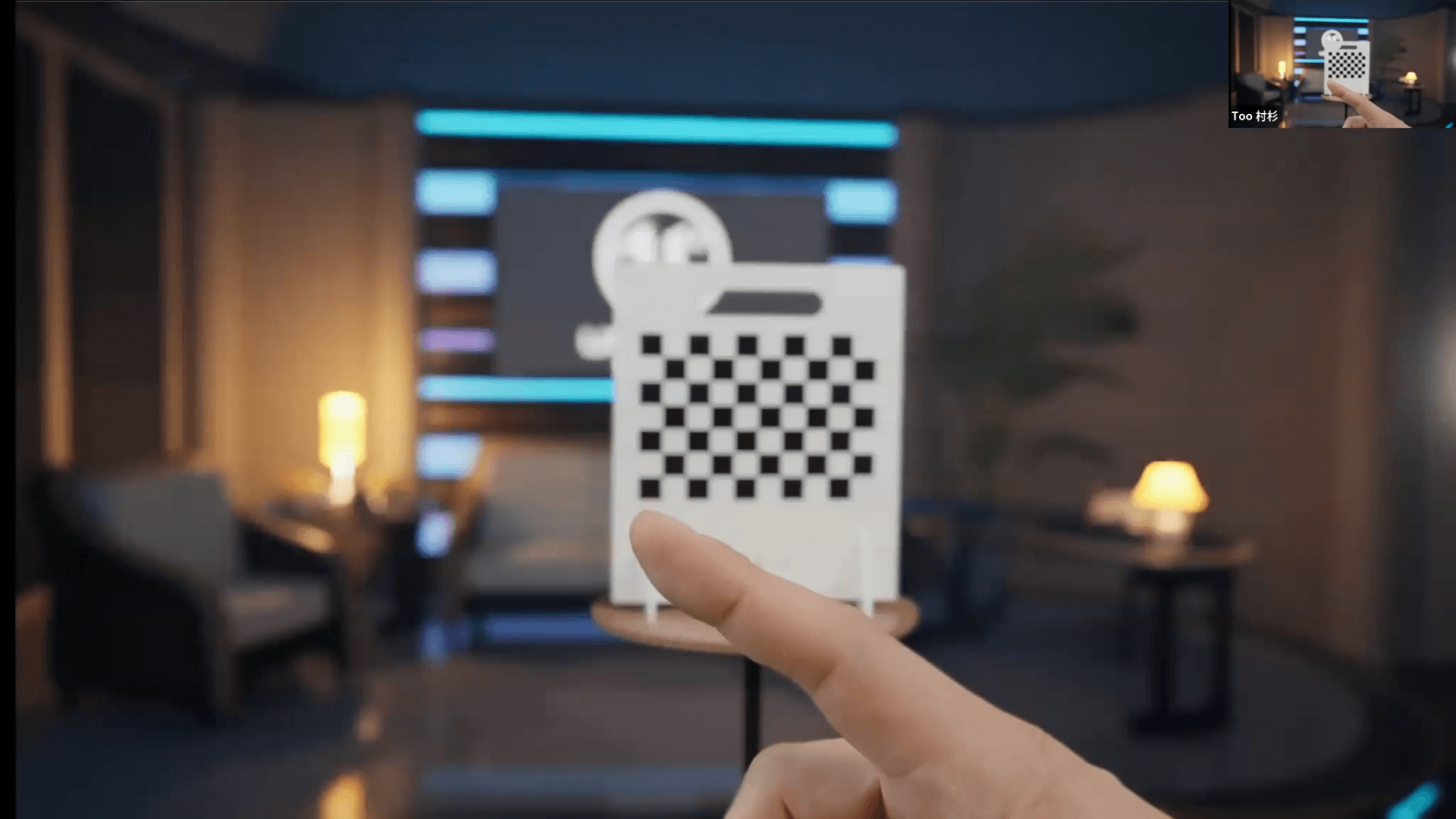

ここからは、実際にUEとVIVE Marsが繋がった状態がどのような画面構成になっているのか簡単にお見せします。本日はモデルがいないため、キャリブレーションボードをモデルとさせていただきます。

接続している構成ですが、VIVE Mras本体をWindows PCとLANケーブルで繋いであります。カメラの映像はBlackmagicのUltimatte 12HDに繋いで、グリーンバック合成を行っています。PCから出たUEの映像はDeckLink経由でUltimatteに入って、バックグラウンドとしてCGデータを入れています。

今回、ビデオソースはDeckLinkでキャプチャしていますが、AJAでも問題ありません。センサーのサイズはカメラに合わせて入れてください。Blackmagicのスタジオカメラに合わせた数値になっています。

しっかり繋がっていると、左側のメニューにある各ツールがグリーンに点灯します。これがキャリブレーションが出来る状態です。しかし、ピントが合ってない状態だとキャリブレーションが失敗するため、ピントを合わせてからキャリブレーションを行なうようにしてください。

本来のキャリブレーションボードでは、トラッカーとローバーの組み合わせをキャリブレ―ションボードに付けて、カメラの上にもトラッカーとローバーがあります。その距離と位置、カメラの映像を見て、レンズキャリブレーションを行っていきます。ここで歪みの検出もしています。

「実際のトラッカーとローバーはカメラの上にあるのに、センサーの位置の情報ってどのように取っているの?」という質問をよく受けます。恐らくですが、高さなども見ているはずです。センサーから見えている映像と実際の高さの位置で三角形ができて、その位置を検出し、センサーの位置などのデータを計算していると考えています。

そのため、他のキャリブレーションツールでは手動でやらないといけない部分も多いのですが、こちらでは手動でやる設定はほとんどありません。1度キャリブレーションを取れば、そのまますぐにUEにデータを持っていけます。

現状では、このキャリブレーションに対応しているのがUE5.0から5.4になります。また、バーチャルプロダクションを得意としている『Aximmetry』という別ソフトもあり、こちらからでもカメラキャリブレーション設定を書き出すことが可能です。

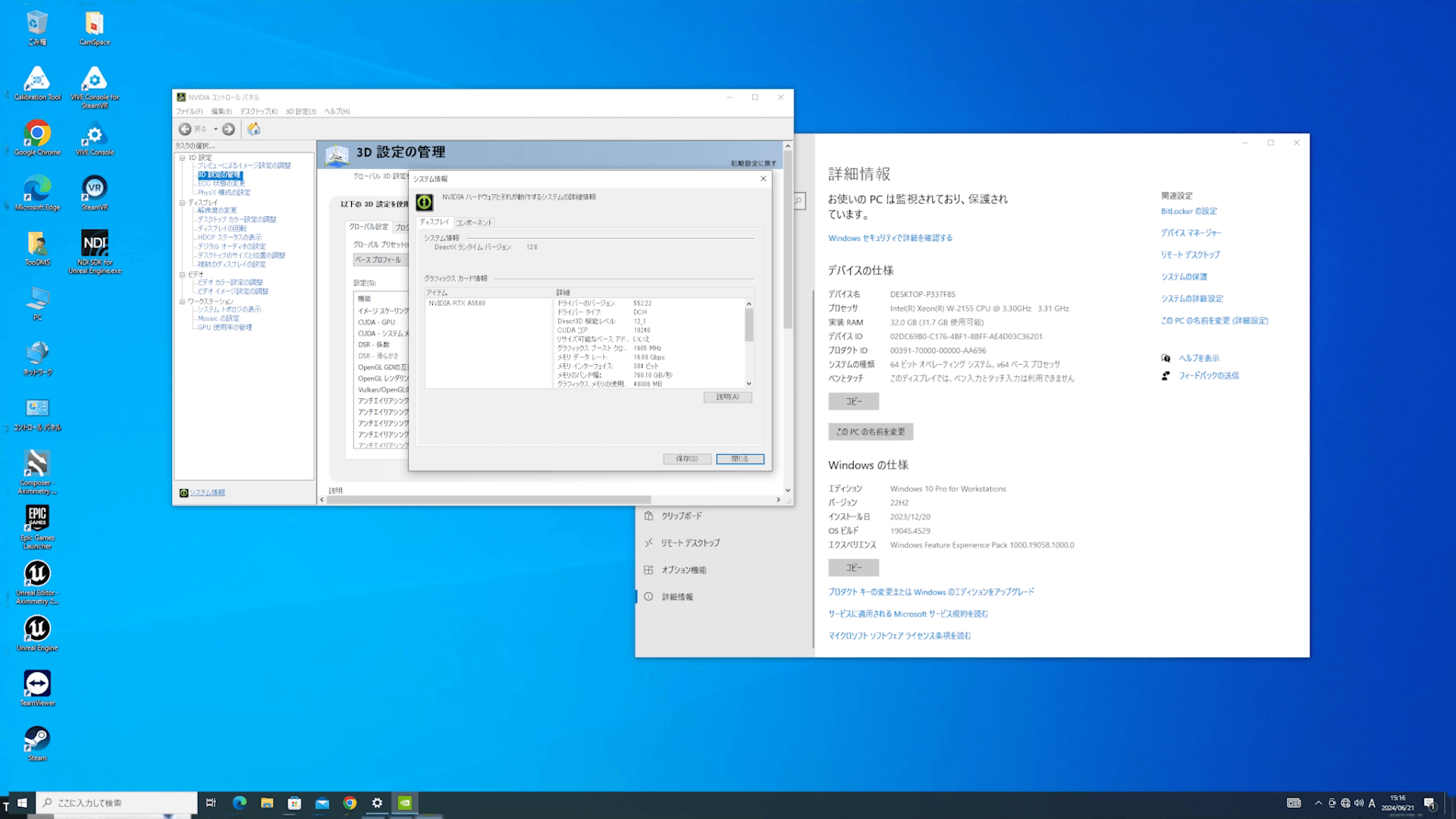

今回のマシン構成ですが、正直GPUが少し貧弱なマシンになっています。「じゃあこれで動くの?」と言われると、結論から言うとあまり綺麗には動きません。本日はあくまでもデモということで、完璧な状態で見せられる状態にはなっていません。使用しているGPUはRTXのA5500で、良いグラフィックボードではありますが、少しパワー不足が見受けられる気がしています。

実際に作る時には、映画・テレビ・ライブ・イベントのところにあるブランクから作るのが良いと思います。バーチャルプロダクションの良いところは、UE上でグリーンバック合成を行う場合になります。その場合に、全ての設定が入ってくるため楽というわけです。一方であまりクオリティは高くないため、外に出して合成するのであればブランクで良いのかと思っています。

UE上での動き

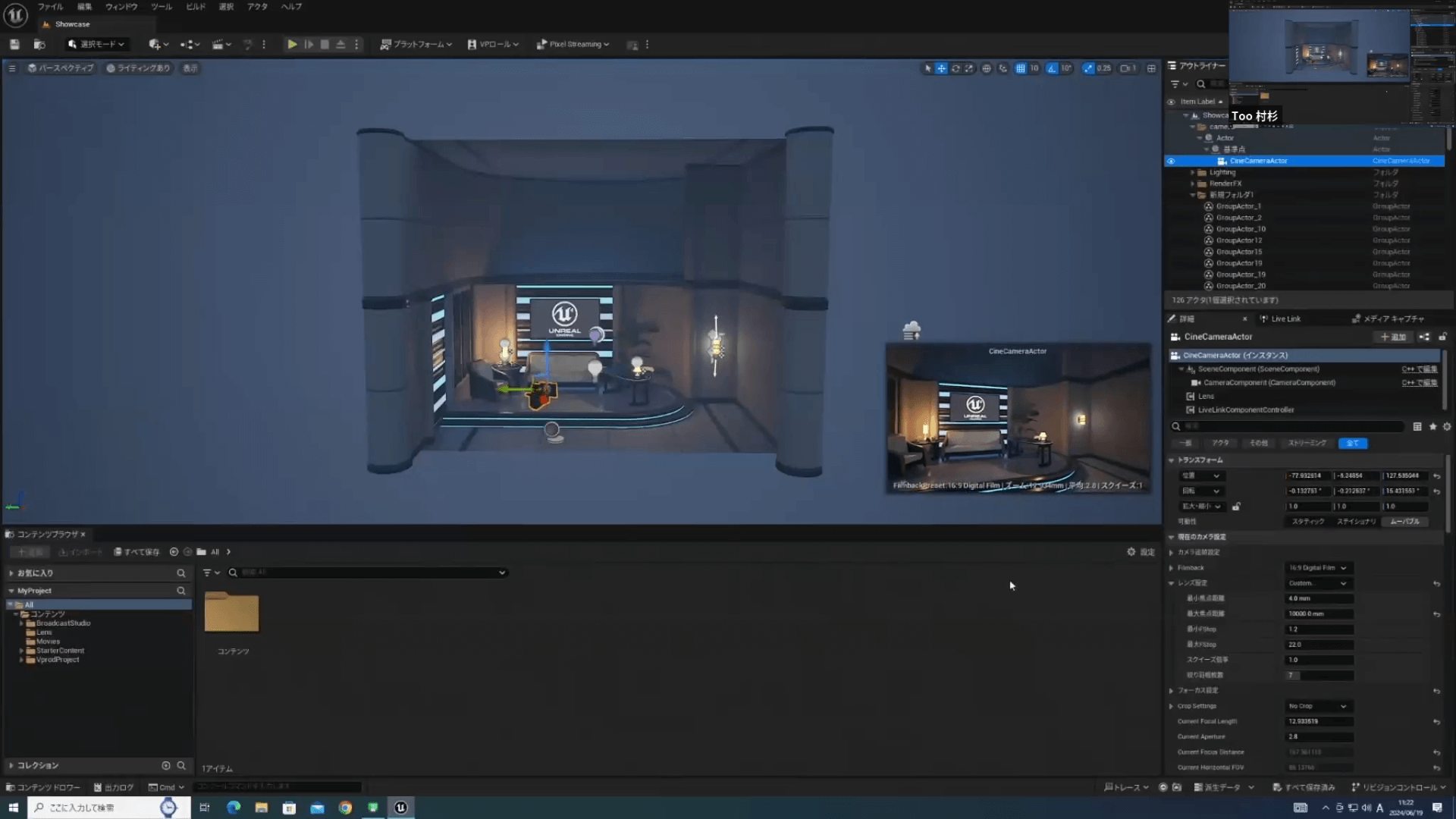

ではプロジェクトを開いていきます。

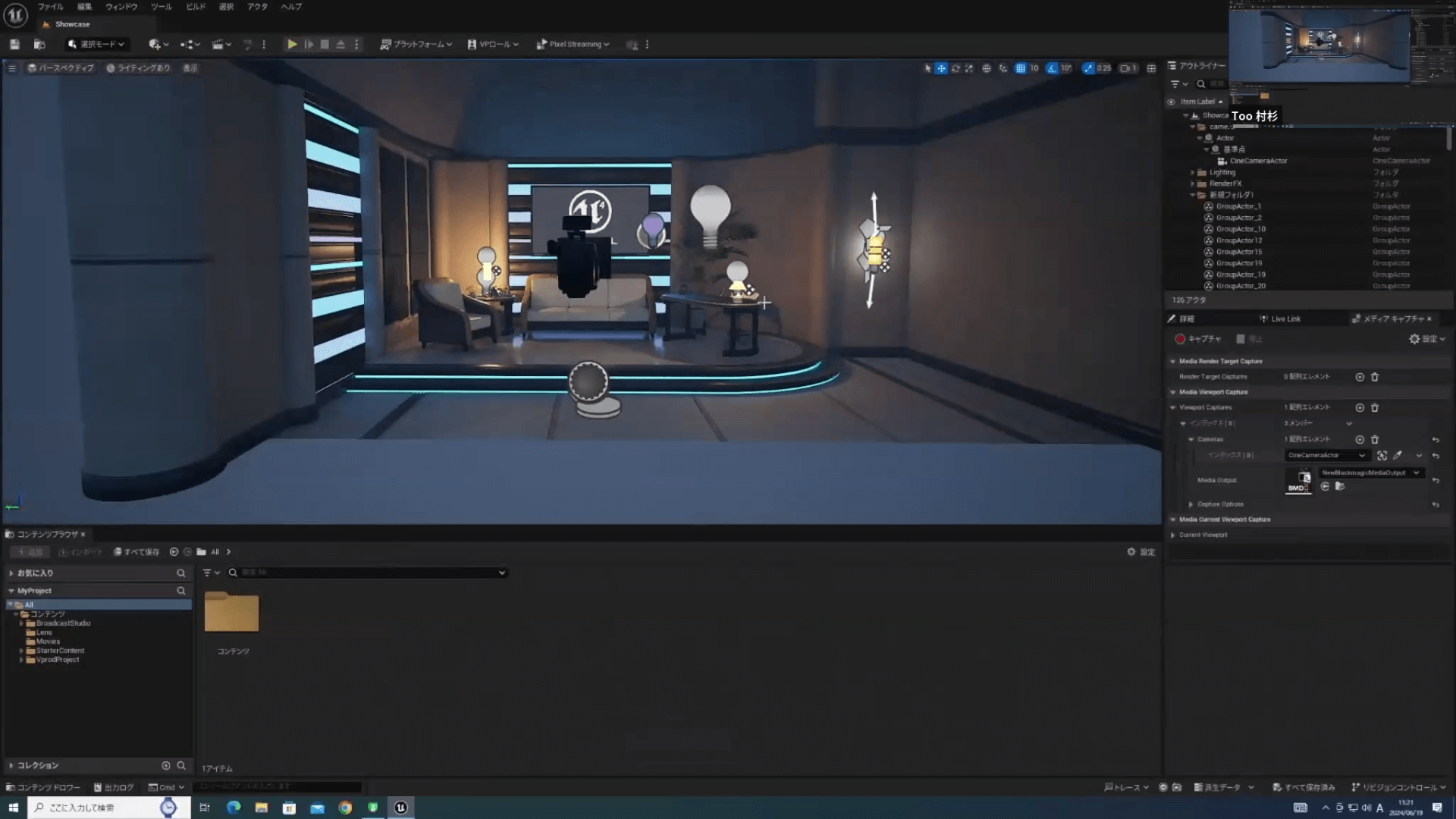

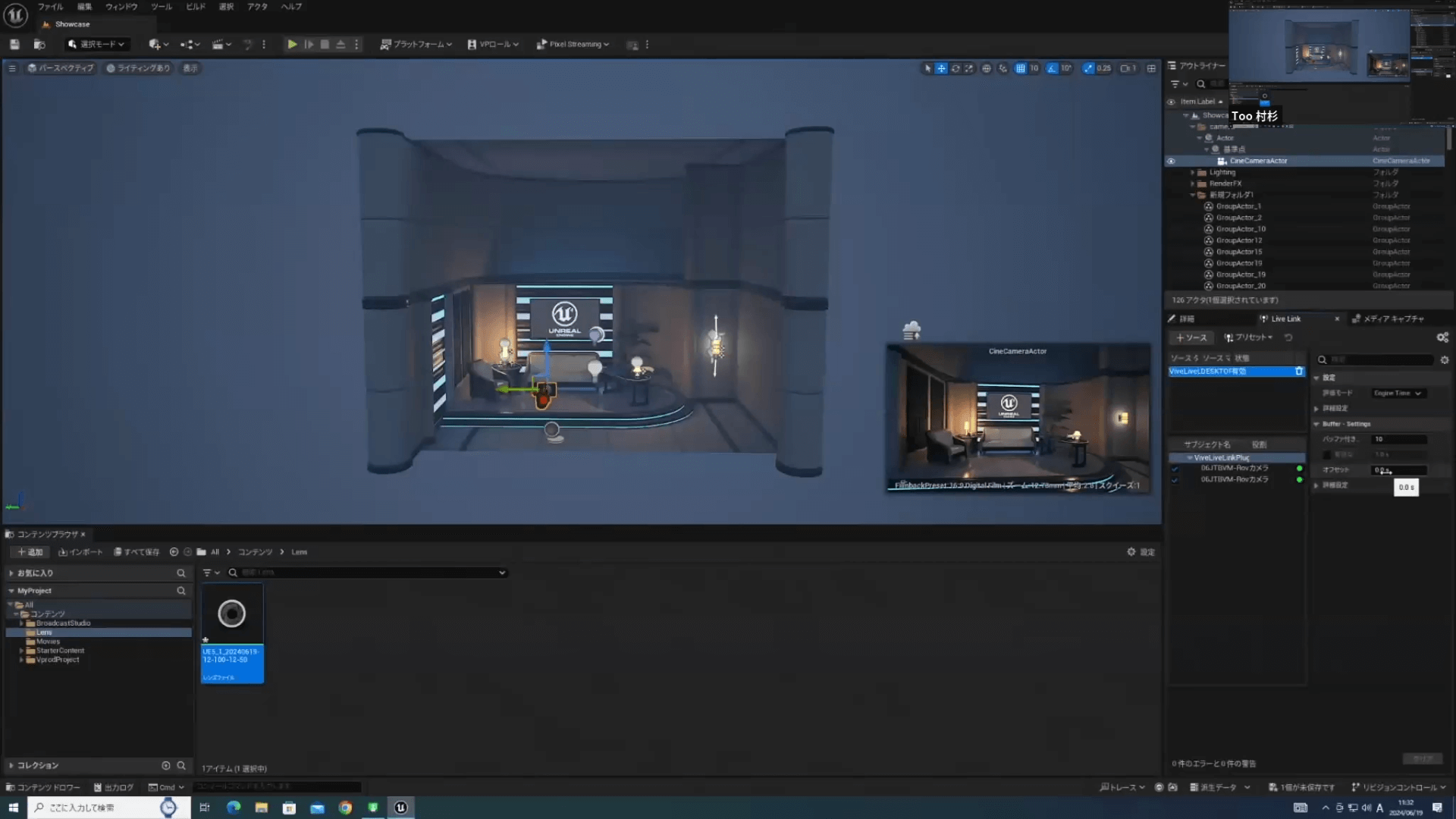

このようなシーンですが、これは無料で配っている3個のスタジオが並んでいるものから不要なものを取り除いたものです。全て設定してあるのですが、現状ではカメラを動かしても動きません。

そこで、Live Linkという設定があります。これがUEとMarsを繋ぐものなのですが、起動するたびに毎回繋ぎ直す必要があります。そうすると、リンクされてカメラが動くようになります。

次にCine Camera アクタを動かしてみます。これに関してはマシンのパフォーマンスなどによってディレイも変わってくるため、性能によってシーンも変える必要があります。

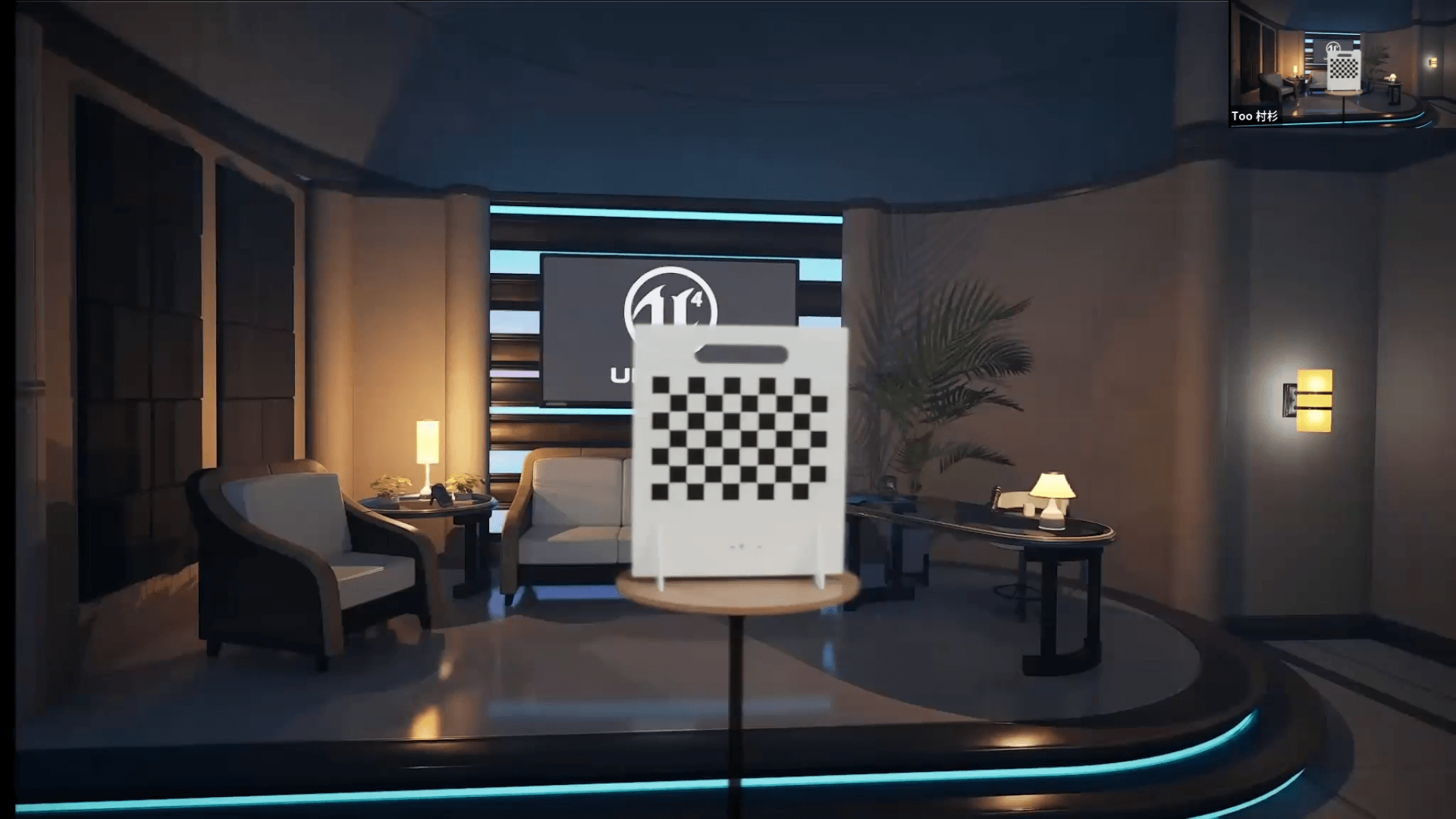

実際に合成した結果を見ていきます。

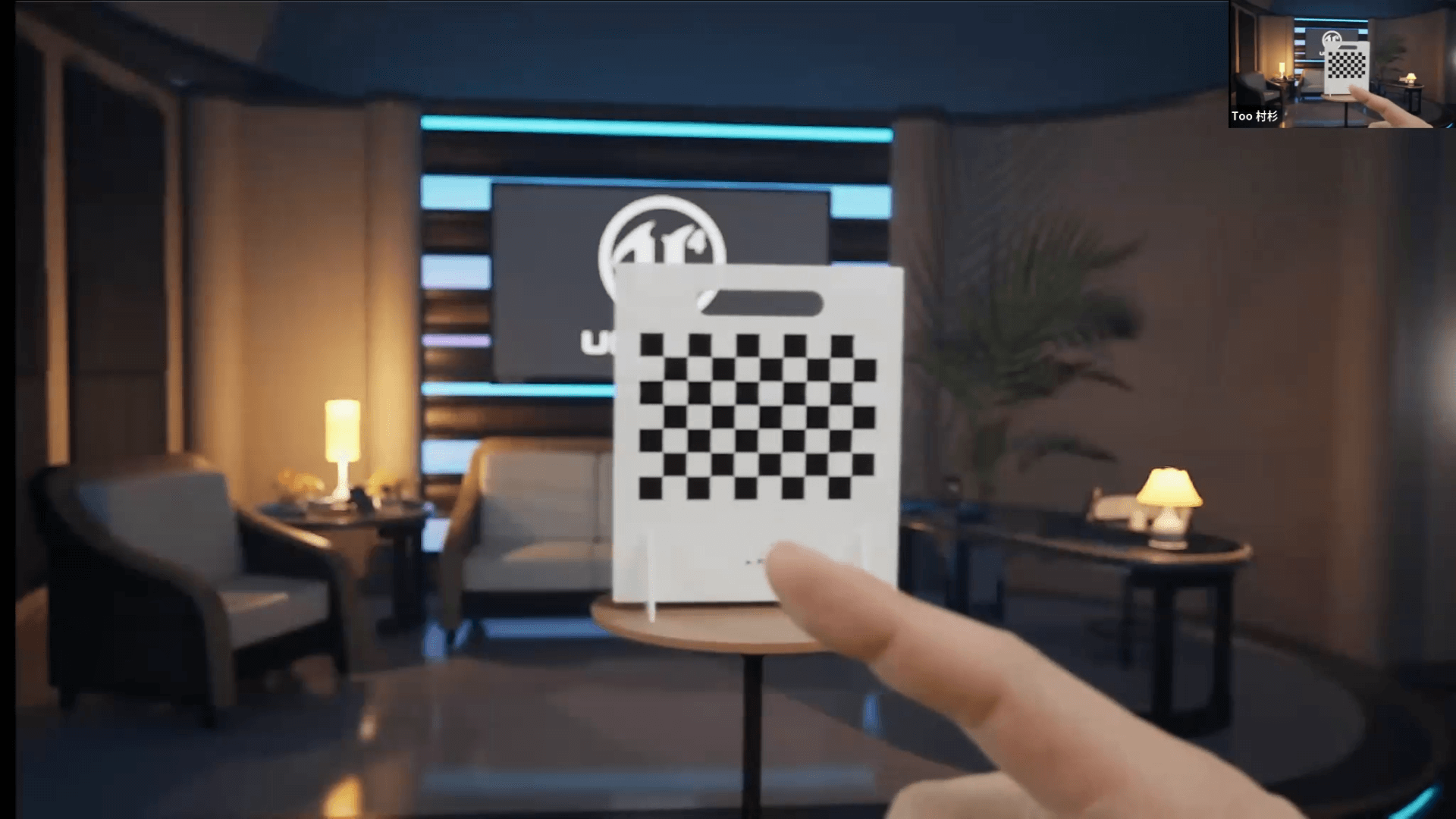

こちらが合成結果です。ただのボードが映っているだけのため、見栄えが良いものではありませんが、少し動かしてみます。FIZTrackでズームやフォーカスが設定できるオプションも付けているため、そちらも合わせて見ていきます。

まずは、横に振ってみます。分かりづらいですが、右上の画面と比べるとUEの方が少しカメラが早いです。理由としては、カメラにディレイかかっているためです。そこで、カメラのディレイをUltimatteでかけています。追加で設定すると、ディレイも細かく調整できます。ズームは12mmから50mmまで設定しています。

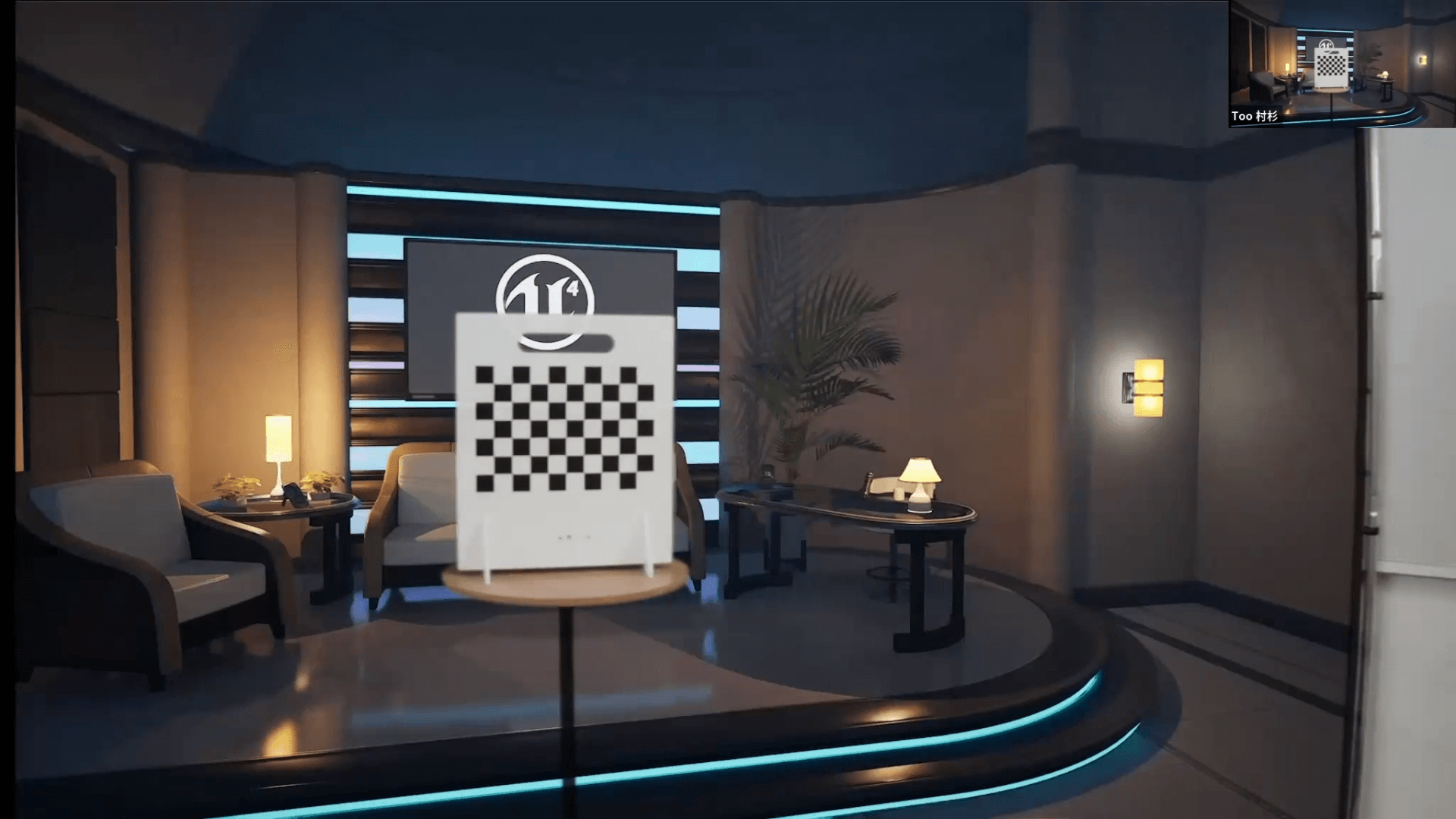

次にフォーカスも触っていきます。このように後ろと連動してフォーカスも動きます。

焦点距離によって絵が変わる様子もお見せします。画像のように私の指にピントを合わせると、後ろの方がぼけて指のみしっかりと見えます。一番後ろにあるUEのロゴは手前のキャリブレーションボードよりも更にぼけているため、しっかりと距離を測っていることが分かります。

今度はキャリブレーションボードにピントを合わせていきます。指にピントが合わなくなり、後ろのロゴも少しぼけた状態になります。このように、キャリブレーションを1度取れば、同じカメラとレンズの構成、同じ位置に設定するだけで簡単に再現できます。そのため、あまり詳しくない方でも簡単に使えるということがメリットになるわけです。

FIZTrack

ここからは、FIZTrackの動きについてお見せします。

FIZTrackの形から気付く方がいるかもしれませんが、おそらくSmallRigのOEMです。こちらもSmallRigのアシストフォーカスの器具があると、ワイヤレスでモーターを動かすことが可能です。今回私も用意したかったのですが、2、3ヶ月待ちという状況で間に合いませんでした。

調整をする際に、レンズを直接触るのは簡単ではありません。ロッドも付いてる中で数字で見ながら調整するのは大変なため、ワイヤレスで動かした方がやりやすいです。

今回は手動で動かしてみてますが、数字が動いている様子が確認できます。この数値でキャリブレーションを取り、VIVE Mars本体にデータをUEに送って、動きについて計算をしています。USBでローバーと繋がっていて、抜けると何も使えなくなってしまうのでケーブリングだけは気を付ける必要があります。

UE上でのデモ

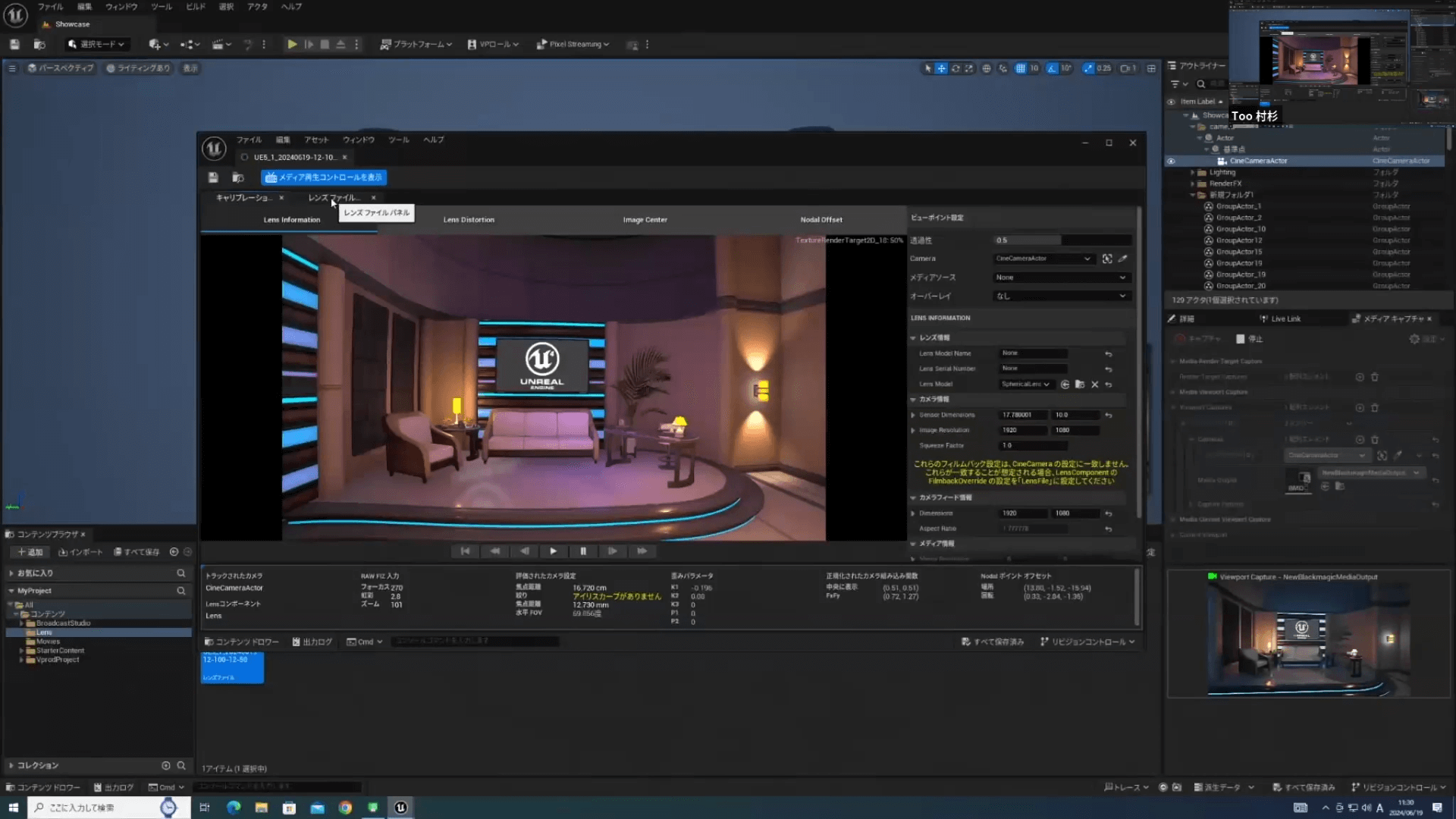

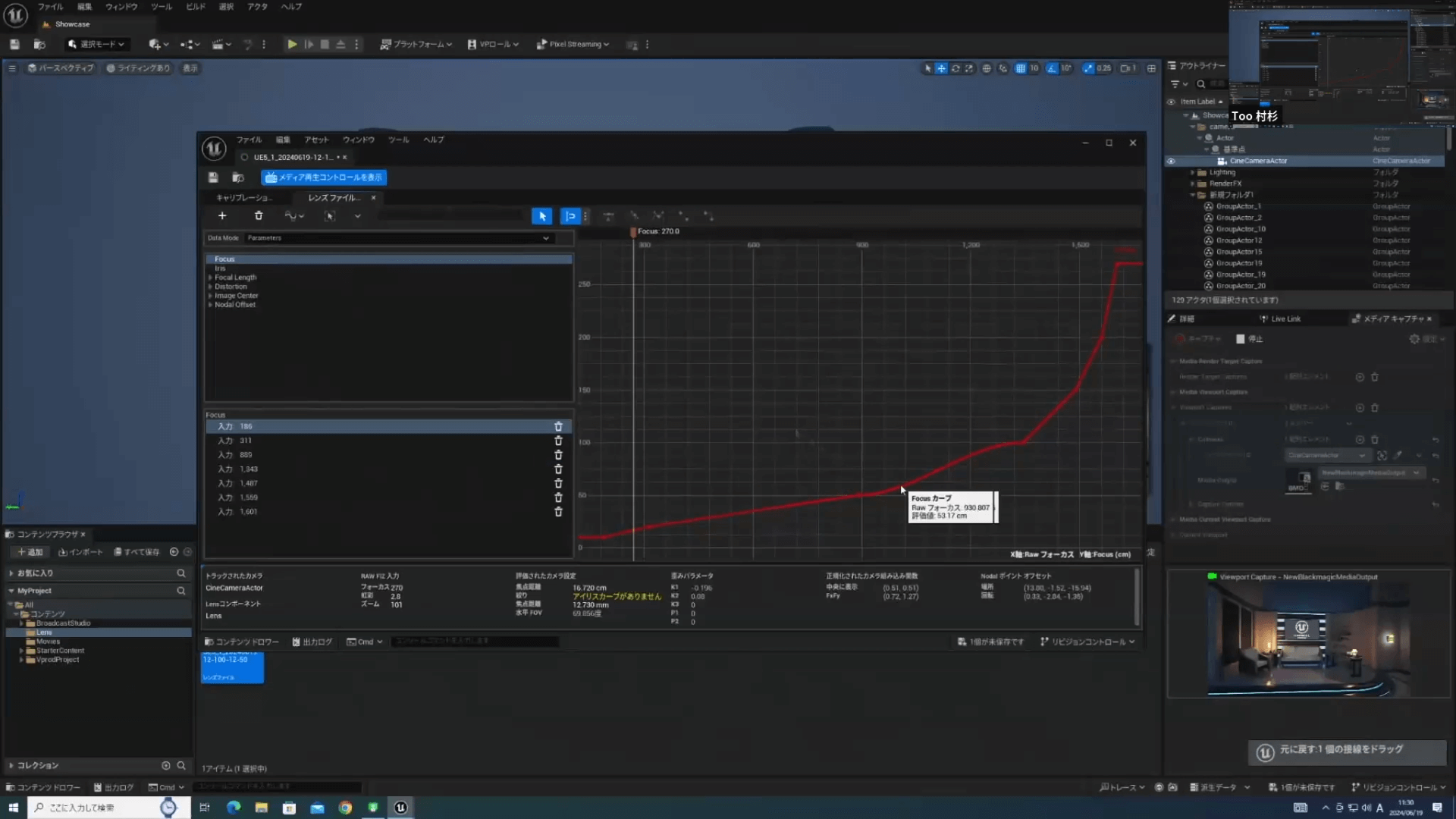

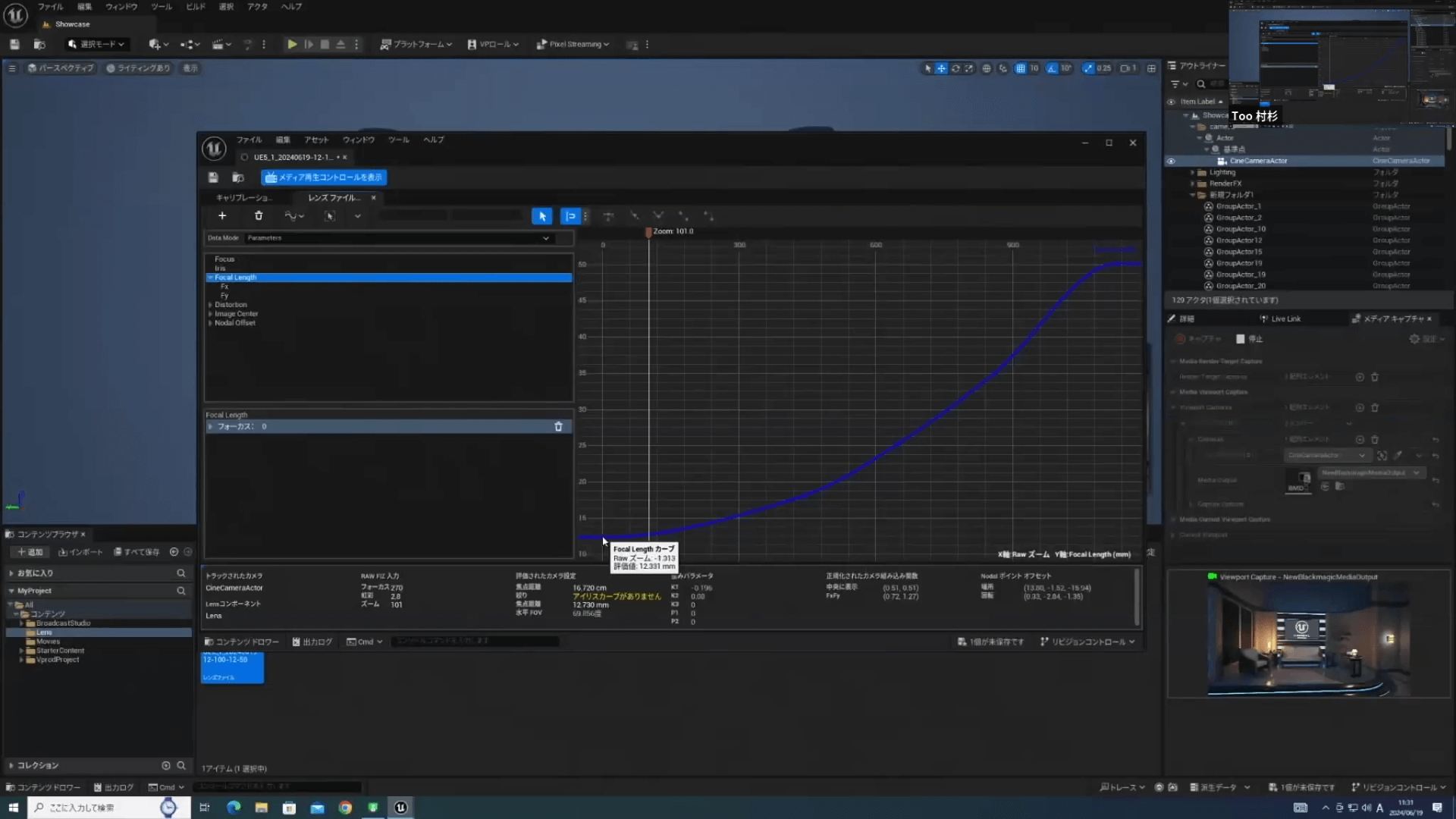

ここからはPCの映像に戻ります。もうひとつお見せしたいのがレンズデータです。実際に今のデータの動きを見ていきます。VIVE Marsのキャリブレーションツールで取ったキャリブレーションデータをUE上で開いていきます。

これはバーチャルカメラに適応しています。レンズファイルを見ると私がフォーカスした焦点距離で撮った図ですが、UE上だと触ることができます。

焦点距離が少し合っていないというケースもありましたが、手動で直すこともできます。また、追加で入力していくことも可能ですし、ベジェカーブをかけて滑らかな線にすることもできます。

フォーカスに限らずズームに関しても同様です。ズームも曲線を描いていますが、ズームのmmなどの位置関係と画面の大きさ、距離で見ているため少しずれています。

今回は12mm-100mmのレンズを使っています。画像にある通り、12mmで撮ったものも12.331mmになっています。こういうケースでも手動で直すことが可能です。12mm以外の18mmと25mm、35mm、50mmは合っていました。より正確なデータを取りたい場合や手直ししたい場合は、このツールを使うと良い映像を撮ることができます。

最後にディレイの件ですが、少しだけ補足します。ディレイには2つのかけ方があり、1つ目はUE上でかけるディレイになります。バックグラウンドのUEから出力される映像にディレイをかけるため、LiveLinkで「Vive LiveDESKTOP有効」になっているものですが、クリックするとオフセットが出てきます。

このオフセットを触ることでディレイをかけられます。これは出す信号をバックグラウンドの信号ディレイにかけるため、大体バックグラウンドの方が遅くなります。カメラの方が早くなることが多いです。

それでは困ることがあるため、Ultimatteでディレイをかけています。UltimatteのSettingの中のインプットから、インプットディレイをかけられます。これを大体4〜6フレームかけて、カメラを少し遅くした後にバックグラウンドの映像を細かく指定します。Ultimatteではフレーム単位ですが、こちらはmm/sec単位かつ小数点も追加できるため、調整して合わせることが可能です。

VIVE Marsは他のシステムに比べると比較的安い製品ではありますが、とても細かいところまで微調整も可能です。タイミングやオフセットなどはUltimatteを使えば細かいところまで設定できるため、精度の高い映像を撮ることができます。

VIVE Mars CamTrack導入企業のご紹介

弊社でVIVE Marsを取り扱い始めて1年ほど経ちますが、様々なお客様に採用されています。導入いただいたお客様のうち4社をご紹介します。どのような企業で、なぜMarsを選んだのかなどを簡単に説明していきます。

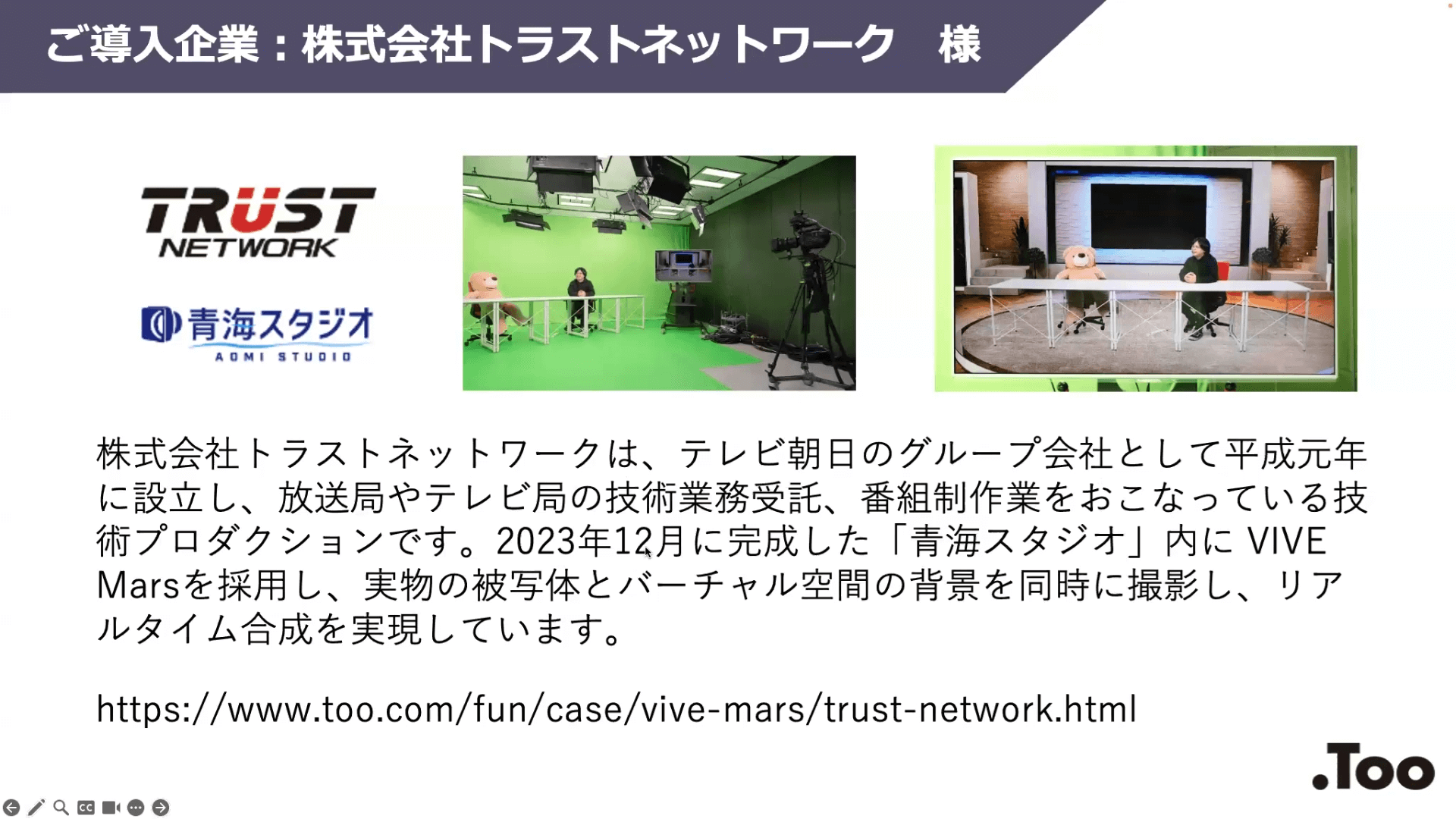

株式会社トラストネットワーク

1社目は、トラストネットワーク様です。テレビ朝日のグループ会社として平成元年に設立し、放送局やテレビ局の技術業務受託、番組制作業務を行っている技術プロダクションです。2023年12月に完成した青海スタジオ内にVIVE Marsを採用し、実物の被写体とバーチャル空間の背景を同時に撮影し、リアルタイムの合成を実現しています。

トラストネットワーク様に関しては、取材に応じていただいた結果を弊社のホームページに事例記事として掲載しています。興味がある方はそちらの記事も見てみてください。会社の成り立ちから、VIVE Marsを採用した仕事内容などが記載されています。

https://www.too.com/fun/case/vive-mars/trust-network.html

株式会社テルミック

2社目は、株式会社テルミック様です。VIVE Marsを採用している企業の9割以上はグリーンバックなのですが、テルミック様は所有しているLEDのスタジオで運営しています。LEDスタジオの『テルスタ TELMIC Studio Soka』は、バーチャルプロダクションに特化したスタジオでLEDビジョンが設置されています。VIVE Marsが機能する上で最適な規模感や、あらゆるカメラやレンズに対応する扱いやすくシンプルな機能性が導入の理由とのことです。

株式会社日経ビデオバンク

3社目は株式会社日経ビデオバンク様です。日本経済新聞社とテレビ東京系列で、主に報道番組の撮影や配信、スタジオ技術を担当する技術会社です。VIVE Marsをいち早く導入しました。

テレビ東京がテクノロジーでコンテンツ価値を高める専門チーム『Tech Lab(テック・ラボ)』を創設したことに準じ、現場単位で簡易なXR技術を取り入れていく方針を掲げました。そして持ち運びできるバーチャルプロダクションを活用し、「伝えるを確かな技術で」をコンセプトにあらゆる場面で表現の選択肢を広げていっています。

写真右上にもあるように、簡易的なグリーンバックのスタジオを所有しています。実際に企業の会議室などに持ち込み、スタジオ収録なども簡易的に行うなどして運営をしてもらっています。

株式会社ハウミック

最後は株式会社ハウミック様です。南麻布のMICStudioでは、グループ会社含め音楽マネージメント事業やテレビ番組制作などを行い、数年前より防音設備やグリーンバックなど完備の配信スタジオも運営しています。

VIVE Marsの導入目的は、今後のグリーンバックの活用方法を考え、スタジオのサイズにとらわれない空間演出を行って魅力的な映像を制作したいと考えたとのことです。上の写真にあるようなスタジオにVIVE Marsを取り入れて運営をしていくとのことで、今さまざまな準備を進めているようです。

今回紹介したのは、映像の制作会社や撮影をされる会社がほとんどでした。一方で、今回は事例を紹介できませんでしたが、製造業でも実際に作った製品を撮影したり、メーカーの企業でも企画関係の仕事に採用してもらったりしています。また、学校でのカリキュラムに取り入れるなど教育機関での採用もあり、さまざまなところで活用してもらっています。

質疑応答

Q1. おすすめのカメラはありますか?

金額などもあるため難しいですが、私の一番のおすすめはBlackmagicの『URSA』です。金額的にも高いですが、性能面を考えると安いですし、多種多様なレンズが揃っているのも魅力です。海外での事例が多いという点もおすすめする理由のひとつになります。

しかし、このカメラは大きくてコンパクトなスタジオでは使いづらいという欠点があります。リファレンスなども付いている方が良いのですが、絶対必要というわけでもないです。少しクオリティを下げても良いのであれば、付いていないカメラでも大丈夫です。

その点では、Sonyの『FX3』や『FX6』などのカメラは画質もよくコンパクトなので、使いやすいと思います。難点としては、Sonyのほとんどのレンズはフォーカスがずっと回り続けるため、FIZTrackを使う際にロックがかけられない点があります。ずっと回り続けてしまうため、動かす範囲を決めないといけないというところがデメリットです。そういった点からも、Sony系よりはCanon系のレンズ、もしくはPanasonicの『マイクロフォーサーズ』などの方が使いやすいと思っています。

参考までに、弊社で使っているBlackmagicのスタジオカメラを紹介します。使用理由のひとつがケーブリングです。バーチャルスタジオで移動しながら使いたい際に、スタジオカメラではLANケーブル1本で電源やリファレンス、映像信号などを送ることができます。

そのため、このカメラに関してはローバーのLANケーブルとスタジオカメラ用のLANケーブル2本だけで済みます。ケーブルも軽く、扱いがとても楽なのは良い点になります。

しかし、レンズがビデオレンズではないため、ズームしてフォーカスを合わせて引いても結局ピントが合っていません。そのため実際のUEで使った際のズームとフォーカスの両方をFIZTrackで使いたい場合には不向きです。つまり、単焦点レンズを使う場合にはとても良いということです。もしくは、歪みが少ないのであれば安いハンディカメラでも良いかもしれません。

Q2. FIZTrack以外で連動できる製品はあるのでしょうか?

現状は純正品しかありません。トラッカーとローバーが繋がっているところに指定されたUSBを繋ぎます。

このローバーのところにUSBが繋がっていますが、このUSBに何を繋ぐのかが決まっています。トラッカーは一番右上、右下はズーム、左上がフォーカス、左下がアイリスと決まっているため、指定したデータを送る必要があります。そのため、FIZTrack以外は対応していないと考えられます。

Q3. トラッキングデータ記録はできるんでしょうか?

記録できるものは現状ありません。しかしUE上などでは記録できる可能性もあるため、その辺に関しては試してみるしかありません。

Q4. RTX4090であれば不便なく動きますか?

UEに関してはどのようなデータを作るかによって変わるため、一概には言えません。ライティングやオブジェクトの数、フィールドの広さ、HDか4Kか、出力数などによって大きく変わります。ただ、RTX4090はコスパが一番良いと思っています。

それでも無理な場合は、『RTX 6000ada』という選択肢になります。個人的な意見ですが、RTX4090で収まるデータを作るようにするのがコストパフォーマンスが高いのではないかと思います。

Q5. カメラの入力は同時に何台いけますか?

これはDeckLinkの入力数によります。しかし、UEで処理をする関係上、UEの方でグラフィックボードの性能に関わってきます。

とある会社の事例では、カメラ1台につきUEのワークステーション1台用意し、それをUEのサーバーに繋いで、全てを同期して一気にやるという方法を取っているそうです。そのため、1台のPCでいくつまでいけるかというと、シーンや使い方によっても変わりますが、最大限頑張ってもHDで3つが限界だと思います。

Q6. 初期セットアップにはどういう作業があって、どの程度の時間がかかるのでしょうか?

キャリブレーションさえ終わっていて毎回同じ場所に設置できれば、それほど時間はかかりません。通常のスタジオの設営と同じくらいの時間帯で終わると思います。一番時間かかるところがレンズのキャリブレーションなので、上手くセッティングすれば時間を短縮できます。

Tooからのご案内

Blackmagicdesign

最後に、Tooからのご案内です。本日の環境でもさまざまなお話をしましたが、VIVE Mars以外にもMarsを繋ぐ、もしくは UEを入れるワークステーションやカメラ、合成のためのBlackmagicのUltimatteなどのさまざまな周辺機器が必要になります。

これらも弊社で取り扱っていますし、一緒にご提案することもできます。今回はBlackmagicしか出てきていませんが、他の周辺機器やワークステーションに関してもご相談対応可能です。

Aximmetry

「UE以外に、Aximmetryは使えないのか」というお話も聞くことがあります。Aximmetryに関して私達もまだまだ勉強中で、テスト検証中というところですが、Aximmetryも製品の取り扱いはしています。ワークステーションや周辺機器、ソフトウェアに関しても、お問い合わせやご相談いただければ可能な限りご提案していきたいと思っていますので、よろしくお願いします。